Analysis

O AWS Re:Inforce 2025 contou com uma sessão dedicada à construção de uma fundação forte e flexível para a segurança da inteligência artificial

Por Rui Damião . 18/06/2025

|

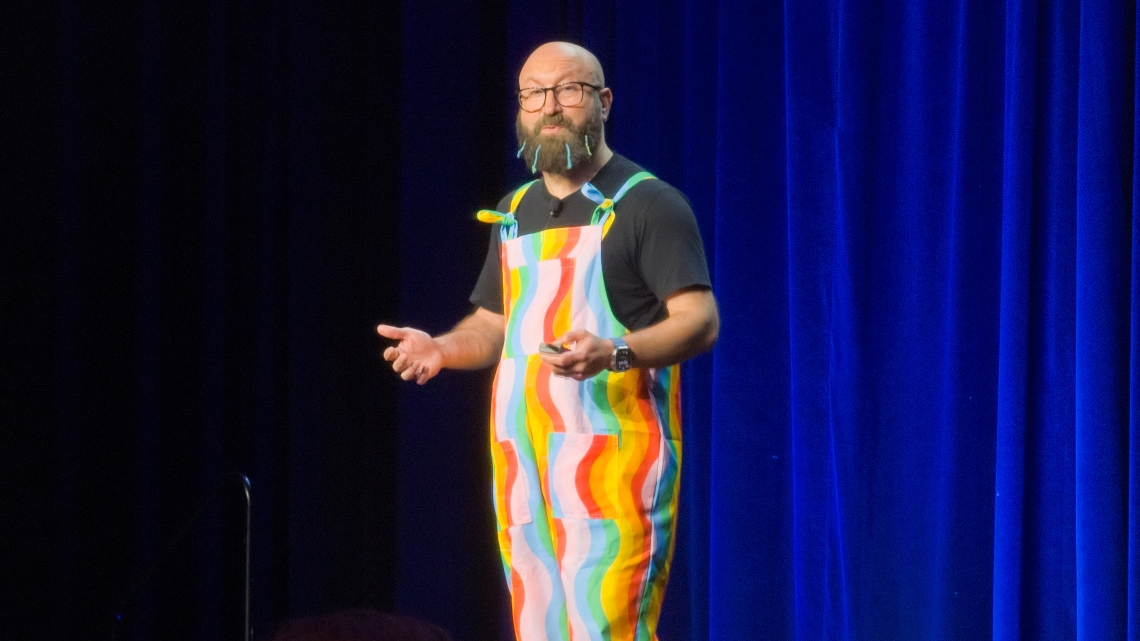

Hart Rossman, VP Security, e Becky Weiss, Vice-President / Distinguished Engineer, ambos da AWS, subiram ao palco de uma das sessões paralelas do AWS Re:Inforce 2025 para falar do tema de segurança da Inteligência Artificial (IA) nas organizações, numa apresentação intitulada “From possibility to production: a strong, flexible foundation for AI security”. “Há alguns anos, a IA generativa explodiu e as organizações enfrentaram uma questão: como inovamos rapidamente e utilizamos esta tecnologia, mas em segurança?”, afirmou Rossman. “Devemos levar a IA generativa e machine learning para todos os aspetos das nossas operações; é imperativo atual e vai definir o futuro da segurança”, explicou Hart Rossman. A segurança da IA tem vindo a evoluir desde as provas de conceito – com experiências em silos e uma abordagem limitada – para implementação em escala para, por fim, implementar em toda a organização, com a segurança como um enabler. Esta não é apenas uma nova forma de implementação e desenvolvimento tecnológico, diz Rossman; “à medida que a IA generativa começa a estar embebida em toda a organização, há novos ganhos para a operação, mais produtividade. Esta integração significa que precisamos de controlos de segurança em todo o stack de tecnologia”, diz. No entanto, não é sobre proteger uma aplicação ou um workload, é “sobre construir fundações de segurança em toda a organização. Devemos ter aquela ideia de defesa de castelo medieval”, refere o VP Security da AWS. Nesta “defesa de castelo medieval”, a base deve contar com as políticas, procedimentos e awareness para a estratégia de inteligência artificial generativa e de como a segurança pode acelerar a adoção. No segundo patamar, deve estar a gestão de identidade e acesso. No terceiro degrau deve estar a proteção da infraestrutura. Depois, à medida que se sobe este castelo, devem estar as proteções de rede e edge e a proteção de aplicação. “Só depois de fazermos isso tudo é que devemos pensar em como é que a aplicação trata os dados. Temos de precaver as alucinações”, explica. No topo de tudo, devem estar a deteção de ameaças e a resposta a incidentes. A evolução da mentalidadeRossman defende que a IA generativa vai levar a uma evolução da mentalidade de segurança dos líderes de segurança das organizações. “Não devemos pensar na IA generativa como outro sistema, devemos pensar como uma nova entidade que traz uma nova perspetiva e uma nova experiência”, afirma. Este paradigma de “tradicional” para “generativo” tem diferenças. No acesso a dados e API é baseado em outputs estruturados, com respostas determinísticas e autorização para acesso aos dados. Com a IA generativa, os outputs são em linguagem natural não estruturada, respostas não determinísticas – “mesmo quando se faz a mesma questão duas vezes, a resposta varia” – e dá-se autorização aos modelos, não aos dados que estão na base desse modelo. Assim, a inteligência artificial precisa de uma fundação segura. O AWS Nitro System é “o melhor exemplo da filosofia de segurança da AWS. Fornece um nível de segurança que não se consegue atingir com software tradicional baseado em hypervisors”, explica. O AWS Nitro System “é o sistema que fornece a base da inovação. Quando se tem a fundação de segurança, é possível inovar mais depressa e com mais confiança”, refere Hart Rossman. O VP Security da AWS defende, também, que adotar um novo modelo de segurança necessita de uma mentalidade de segurança, onde só se devem utilizar pacotes de software aprovados, os modelos devem ser alojados na conta sem acesso a Internet externa, logging forte para todos os modelos, validação dos inputs para execução de código remoto no modelo de container e com IAM a impedir acessos não autorizados. A AWS fornece guardrails para avaliar os prompts e as respostas dos modelos, faz a validação dos inputs e os outputs dos prompts e conta com reasoning automatizado para detetar erros factuais. Como começar com a segurança na inteligência artificial

Becky Weiss relembrou que as políticas, procedimentos e awareness é a base da inteligência artificial: “são o que define o que é que a organização quer atingir e como se vai conseguir chegar a esse ponto de forma segura”. Weiss deu o exemplo interno da Amazon e da AWS, que introduziram aplicações com IA generativa construído com o Amazon Q for Business com uma implementação de segurança. Foi construído com base em políticas definidas, conta com dados altamente confidenciais e permite fazer questões, fazer resumos de documentos e integrar com outras fontes de dados. Os casos de uso internos tocam várias áreas dentro das organizações. No que toca à área de segurança, as operações de segurança da Amazon contam com um assistente de triagem que analisa milhares de alertas por mês e um companion que fornece capacidades de pesquisa melhoradas, por exemplo. “Todas estas aplicações foram construídas com o Amazon Q e, como outro qualquer serviço da AWS, tem de passar por várias revisões de segurança”, para além de ter de passar em casos de uso que os colaboradores da Amazon iriam utilizar. Ao perceber essas necessidades, foram definidas as fontes de dados e os guardrails necessários para proteger a organização, os dados e os colaboradores. “Qualquer aplicação de negócio moderna – e não precisa de ser de IA generativa – precisa de autenticar os seus utilizadores. A identidade do utilizador autenticado vai afetar a sua experiência com aquela aplicação ou sistema”, explica Becky Weiss, que relembra que “estas identidades não precisam de ser de utilizadores humanos; podem ser de máquinas”. Na era da inteligência artificial, é preciso perceber quem é o utilizador, que permissão tem, que dados está autorizado a aceder. Depois, é preciso perceber que identidade é que a aplicação deve assumir e que guardrails é que o modelo ou a aplicação devem colocar em prática. Numa altura em que as organizações estão a mudar e querem inovar com inteligência artificial de uma forma geral – e generativa em particular – é preciso que a segurança forneça a base necessária para que os utilizadores da organização possam experimentar e inovar novas aplicações nos seus sistemas.

A IT Security viajou até Filadélfia, nos Estados Unidos, a convite da AWS. |